1)Blaise Pascal

(19 de junio1623 en Clermont 19 de agosto de 1662 en París) fue un

matemático, físico, filósofocatólico y escritor.

Los dispositivos de Pascal y Leibniz fueron

los antepasados de las computadoras de escritorio de hoy, y las derivaciones de

estas máquinas, incluyendo la calculadora Curta, continuaron siendo producidos

hasta que a principios de los años 1970 sus equivalentes electrónicos

finalmente llegaron a ser fácilmente disponibles y baratos.

Trabajos para la construcción de la máquina de

calcular («Pascalina»).(1641)

Publicación del teorema que se conoce como

«Teorema de Pascal» (en Essai sur les coniques).(1640)

(1662 )Muerte en París (el 19 de agosto).

2)Gottfried

Wilhelm Leibniz: (1646-1666)

En los años 1670, el barón alemánGottfried

Leibniz llevó el cálculo mecánico un paso más adelante de sus predecesores.

Leibniz, quien entró en la universidad a los quince años de edad y recibió su

licenciatura a los diecisiete años, una vez dijo: "es indigno de hombres

excelentes perder horas como esclavos en el trabajo del cálculo, que, si fueran

usadas las máquinas, podría ser relegado con seguridad a cualquier

persona".

SteppedReckoner

Leibniz extendió las ideas de Blaise Pascal y,

en 1671, introdujo el Staffelwalze/StepReckoner (también conocido como el

SteppedReckoner, o máquina de Leibniz), un dispositivo

que, así como ejecutaba adiciones y substracciones, podía multiplicar, dividir,

y evaluar raíces cuadradaspor una serie de pasos de adiciones.

3)Herman Hollerith (1860-1929).

Es considerado como el primer

informático, es decir, el primero que logra el tratamiento automático de la

información (Informática = Información + automática).

Máquina tabuladora: fue inventada en 1889. Hollerith patentó su diseño en 1884 y en los años siguientes se

dedicó a aplicar su sistema para el cómputo estadístico de datos sanitarios

mientras se dedicaba paralelamente a mejorarlo. En 1887 ya había abandonado las cintas de papel por las tarjetas

perforadas y su sistema se utilizó para procesar los datos sobre mortandad en

Baltimor. Las tarjetas permitían organizar la información de un modo mucho más

lógico que las cintas de papel y facilitaban enormemente la corrección de

datos. Los orificios eran cuadrados para optimizar el uso del espacio y el

tamaño de las tarjetas equivalente al de los billetes de 1 dólar para facilitar

su almacenamiento masivo.

Cada

tarjeta se sitúa sobre varios recipientes abiertos y llenos de mercurio. Por

encima de la tarjeta hay una serie de cables en forma de muelle; un cable para

cada posible agujero en la tarjeta. Cuando este conjunto de cables se presionan

contra la tarjeta, algunos de ellos (los que han quedado encima de un agujero)

pueden llegar a entrar dentro de los botes de mercurio, y así cerrar el

circuito eléctrico.

Después de leer cada tarjeta, la máquina hace varias otras cosas: incrementa un contador, hace sonar una campana para avisar al operario de que ya la ha leído, y abre un cajón concreto en el que almacenar la tarjeta. El cajón elegido depende de lainformación leída de la tarjeta.

Para esta tarjeta (del censo de 1890) se creó esta plantilla que se colocaba en una especie de máquina de escribir, en la parte del operario. La máquina pantográfica trasladaba el movimiento del operario a la tarjeta real, permitiendo así escribir unas 500 tarjetas por día. (Ejemplo, del censo de 1920).

Físicamente, el Memex parecía una mesa con dos monitores accionables mediante lápiz óptico y un escáner. En su interior se almacenaría la información indexada compuesta tanto por texto como por imágenes, siguiendo estándares universales.

6)Norbert Wiener

(26 de noviembre de 1894, Columbia (Misuri) –

18 de marzo de 1964, Estocolmo, Suecia) fue un matemático estadounidense, conocido como el fundador de la cibernética.[1] Acuñó el término en su libro Cibernética o el control y comunicación en animales y máquinas, publicado en 1948.

Su padre, Leo Wiener, fue profesor en lenguas eslavas en la Universidad Harvard. Norbert se educó en casa hasta los siete años, edad a la que empezó a asistir al colegio, pero durante poco tiempo. Siguió con sus estudios en casa hasta que volvió al colegio en 1903, graduándose en el instituto de Ayer en 1906.

7)Claude

Elwood Shannon

(Míchigan, 30 de abril de 1916 - 24 de febrero de 2001), ingeniero electrónico y matemático estadounidense, recordado como «el padre de la teoría de la información».

Estudia el flujo de las ondas electromagnéticas a través de un circuito. Y entiende que a través del código binario se puede homogeneizar todo tipo de información (textos, sonidos, imágenes...). Distingue claramente entre mensaje y el medio por el que éste se transmite. Al tiempo, analiza cómo medir la eficacia de un canal de comunicación a través del concepto de entropía, tomado de la segunda ley de la termodinámica. La entropía mide las pérdidas derivadas de los ‘ruidos’ en la transmisión de información de un mensaje, y, al tiempo, la posibilidad de eliminar las mermas, la incertidumbre, mediante la redundancia y la codificación numérica en el origen del proceso de comunicación y su descodificación en la fase de recepción. Al cabo de más de medio siglo de sus hallazgos se sigue considerando el trabajo de Shannon la pieza clave en el desarrollo que lleva a que la comunicación adquiera un carácter de centralidad en la sociedad actual. Asimismo, sienta los fundamentos matemáticos de la revolución tecnológica de la segunda mitad del siglo XX.Desde el estudio del álgebra 'booleana' teoriza acerca del código binario, la base del lenguaje digital, a partir de unidades básicas de información, definidas por dos estados: el ‘si’ y el ‘no’, el 0 y el 1, abierto/cerrado, verdadero/falso, blanco/negro. El 0 y el 1 aparecen como el átomo de la información, como la base constructiva del mensaje. Una información compleja es una sucesión de unidades básicas, de unos y ceros. Más allá de la formulación teórica, Shannon construyó circuitos y máquinas basadas en los flujos binarios de información, mediante interruptores y relés en las que se anticipaban los embriones de muchos de los desarrollos de las décadas posteriores.

Después de leer cada tarjeta, la máquina hace varias otras cosas: incrementa un contador, hace sonar una campana para avisar al operario de que ya la ha leído, y abre un cajón concreto en el que almacenar la tarjeta. El cajón elegido depende de lainformación leída de la tarjeta.

Para esta tarjeta (del censo de 1890) se creó esta plantilla que se colocaba en una especie de máquina de escribir, en la parte del operario. La máquina pantográfica trasladaba el movimiento del operario a la tarjeta real, permitiendo así escribir unas 500 tarjetas por día. (Ejemplo, del censo de 1920).

4)Vannevar Bush

Nació

el 11 de marzo de 1890

en Everett, Massachusetts y estudió en el TuftsCollege de la Universidad de Harvard

El

primer sistema de hipertexto, el "Memex" o Memory Extended, fue

descrito por Vannevar Bush, Asesor Científico del Presidente de EE.UU.

Roosevelt, en un ensayo de 1945 "As weMayThink".

Primer computador analógico

Para la

realización de cálculos repetitivos diseña el Analizador Diferencial, primer

computador analógico condenado a la obsolescencia por la aparición de la

computadora digital. Este dispositivo permitía la resolución de ecuaciones de

hasta 18 variables y sirvió para cálculos balísticos entre otros.

Memex (Memory Extended)

Sin duda, el dispositivo más conocido por su influencia en la visión del hipertexto e internet fue el Memex. Memex era un dispositivo mecánico en el que un individuo podía almacenar todos sus libros, grabaciones y comunicaciones. Estaba mecanizado de modo que se podía consultar la información almacenada de una forma rápida y flexible (no lineal).Físicamente, el Memex parecía una mesa con dos monitores accionables mediante lápiz óptico y un escáner. En su interior se almacenaría la información indexada compuesta tanto por texto como por imágenes, siguiendo estándares universales.

5)Alan

Turing, el padre de la informática

Alan Turing es

considerado como el padre de la informática y metodología de la computación.

Proporcionó

una influyente formalización de los conceptos de algoritmo y

computación: la máquina de Turing. Formuló su propia versión de

la hoy ampliamente aceptada Tesis de Church-Turing, la cual postula que

cualquier modelo computacional existente tiene las mismas capacidades

algorítmicas, o un subconjunto, de las que tiene una máquina de Turing. Durante

la Segunda Guerra Mundial, trabajó en descifrar

los códigos nazis,

particularmente los de la máquina Enigma; durante un tiempo fue el director de la

sección Naval Enigma del Bletchley

Park. Tras la guerra diseñó uno de los primeros computadores electrónicos

programables digitales en el Laboratorio Nacional de

Física del Reino Unido y poco tiempo después construyó otra de las

primeras máquinas en la Universidad de Mánchester. Entre otras

muchas cosas, también contribuyó de forma particular e incluso provocativa al

enigma de si las máquinas pueden pensar, es decir a la Inteligencia Artificial.

fue

uno de los padres de la inteligencia artificial y creo un procedimiento llamado

'La

prueba de Turing'. Dicha prueba permite identificar la existencia de

inteligencia y básicamente consiste en un desafío. Una de las aplicaciones de

la prueba de Turing es el control de SPAM que hoy en día lo vemos por muchas

webs, el

sitemaCaptcha. La prueba de Turing en éste caso se utiliza para identificar

si los datos o mensajes enviados fueron realizados por un humano o por una

máquina. El programa nos muestra un texto en formato imagen y debemos escribir

las letras, en caso de acertar podremos seguir adelante con el envío.

5) John von Neumann

(28 de diciembre de 1903 - 8 de febrero de 1957)

(28 de diciembre de 1903 - 8 de febrero de 1957)

fue

un matemáticohúngaro-estadounidense

que realizó contribuciones fundamentales en física cuántica, análisis funcional, teoría de conjuntos, ciencias de la computación, economía,

análisis numérico, cibernética,

hidrodinámica,

estadística

y muchos otros campos. Está considerado como uno de los más importantes

matemáticos de la historia moderna.

-Ciencia computacional

Identificación de von Neumann en el Laboratorio Nacional Los Álamos.

Von Neumann

le dio su nombre a la Arquitectura de von Neumann, utilizada en casi todos los computadores, por su publicación del concepto; aunque muchos

piensan que este nombramiento ignora la contribución de J. PresperEckert y John William Mauchly, quienes aportaron al concepto durante su trabajo en ENIAC.12 Virtualmente, cada computador personal, microcomputador, minicomputador y supercomputador es una máquina de von Neumann. También creó el campo de los autómatas celulares sin computadores, construyendo los primeros ejemplos de autómatas autorreplicables con lápiz y

papel. El concepto de constructor universal fue presentado en su trabajo póstumo Teoría de los

Autómatas Autorreproductivos. El término «máquina de von Neumann» se refiere alternativamente a las máquinas autorreplicativas. Von Neumann

probó que el camino más efectivo para las operaciones mineras a gran escala,

como minar una luna entera o un

cinturón de asteroides, es a través del uso de máquinas auto-replicativas, para tomar ventaja del

crecimiento exponencial de tales mecanismos.

Adicional a

su trabajo en arquitectura computacional, von Neumann es acreditado con al

menos una contribución al estudio de algoritmos. Donald Knuth denomina a von Neumann como el inventor, en 1945, del

conocido algoritmo mergesort, en el cual la primera y segunda mitad de un array

(vector) son cada una clasificadas recursivamente y luego fusionadas juntas.

También se

comprometió en la investigación de problemas en el campo de la hidrodinámica numérica. Junto con R. D. Richtmyer desarrolló un algoritmo definiendo viscosidad

artificial, que probó la esencia para el entendimiento de las ondas de choque. Puede decirse que no entenderíamos mucho de astronáutica y ni siquiera habríamos desarrollado jets y motores

espaciales sin ese trabajo. El problema que resolver era que cuando los

computadores resuelven problemas hidro o aerodinámicos, buscan poner muchos

puntos de rejilla (o malla, en inglés grid) computacionales en regiones

con onda de choque de discontinuidad aguda. La viscosidad artificial era

un truco matemático para suavizar levemente la transición del choque sin

sacrificar la física básica.

6)Norbert Wiener

(26 de noviembre de 1894, Columbia (Misuri) –

18 de marzo de 1964, Estocolmo, Suecia) fue un matemático estadounidense, conocido como el fundador de la cibernética.[1] Acuñó el término en su libro Cibernética o el control y comunicación en animales y máquinas, publicado en 1948.

Su padre, Leo Wiener, fue profesor en lenguas eslavas en la Universidad Harvard. Norbert se educó en casa hasta los siete años, edad a la que empezó a asistir al colegio, pero durante poco tiempo. Siguió con sus estudios en casa hasta que volvió al colegio en 1903, graduándose en el instituto de Ayer en 1906.

(Míchigan, 30 de abril de 1916 - 24 de febrero de 2001), ingeniero electrónico y matemático estadounidense, recordado como «el padre de la teoría de la información».

Estudia el flujo de las ondas electromagnéticas a través de un circuito. Y entiende que a través del código binario se puede homogeneizar todo tipo de información (textos, sonidos, imágenes...). Distingue claramente entre mensaje y el medio por el que éste se transmite. Al tiempo, analiza cómo medir la eficacia de un canal de comunicación a través del concepto de entropía, tomado de la segunda ley de la termodinámica. La entropía mide las pérdidas derivadas de los ‘ruidos’ en la transmisión de información de un mensaje, y, al tiempo, la posibilidad de eliminar las mermas, la incertidumbre, mediante la redundancia y la codificación numérica en el origen del proceso de comunicación y su descodificación en la fase de recepción. Al cabo de más de medio siglo de sus hallazgos se sigue considerando el trabajo de Shannon la pieza clave en el desarrollo que lleva a que la comunicación adquiera un carácter de centralidad en la sociedad actual. Asimismo, sienta los fundamentos matemáticos de la revolución tecnológica de la segunda mitad del siglo XX.Desde el estudio del álgebra 'booleana' teoriza acerca del código binario, la base del lenguaje digital, a partir de unidades básicas de información, definidas por dos estados: el ‘si’ y el ‘no’, el 0 y el 1, abierto/cerrado, verdadero/falso, blanco/negro. El 0 y el 1 aparecen como el átomo de la información, como la base constructiva del mensaje. Una información compleja es una sucesión de unidades básicas, de unos y ceros. Más allá de la formulación teórica, Shannon construyó circuitos y máquinas basadas en los flujos binarios de información, mediante interruptores y relés en las que se anticipaban los embriones de muchos de los desarrollos de las décadas posteriores.

8)Charles

Babbage

(1791 - 1871) fue un matemático y astrónomo

británico. Al igual que sus colegas, podría haberse conformado con las máquinas

de calcular existentes en la década de 1830. Existían numerosos modelos de

estas máquinas, todos ellos

capaces de efectuar las cuatro operaciones

aritméticas. Pero Babbage

era un apasionado de la técnica y su proyecto era mucho más ambicioso: quería

construir una calculadora universal que pudiera encadenar automáticamente

cualquier secuencia de operaciones y devolver el resultado final.

La

arquitectura de la máquina de Babbage

era increíblemente moderna para su época. En ella podían encontrase todos los

elementos que componen hoy en día nuestros ordenadores:

·

Una unidad de cálculo.

Donde se efectúan todas las operaciones.

·

Una unidad de memoria.

Donde se retienen todos los resultados intermedios con el fin de que se puedan

buscar y recuperarse en el momento en que el cálculo lo precise.

·

Una unidad de mando. Que

dirige el orden de las operaciones y cuida de que todo se ejecute

correctamente.

Todo el

conjunto era completamente mecánico, a base de ruedas, cilindros de levas y

tarjetas perforadas, que ya se usaban en la industria textil. Además, la máquina de Babbage requería que se

tradujeran los problemas por resolver en secuencias de operaciones, y aquí es

donde entra el primer programador de la historia.

¿Quién fue el

primer programador de la historia?

Ada Lovelace (1815 - 1852), hija del

gran poeta inglés Lord Byron y

excepcional matemática, fue quien se dedicó a esta tarea de traducir los

problemas en secuencias de operaciones en tarjetas perforadas. De esta forma se

convirtió en la primera programadora de la historia.

Durante

bastante tiempo, Babbage envió

los planos de su calculadora mientras que Ada se encargaba de escribir programas que se pudieran resolver.

Si ella se encontraba con dificultades, sugería las modificaciones oportunas

para resolverlas.

¿Cómo acabó todo?

La

máquina de Babbage fue un sueño increíble. Su máquina estaba muy por delante de

su tiempo. Permaneció toda su vida trabajando en ella pero encontró problemas,

la todavía arcaica tecnología de aquella época y su presupuesto, y nunca

consiguió acabarla. Sin embargo, los principios de su máquina siguen siendo

actuales y son la base de los ordenadores actuales.

Considerado como el primer

pionero de la computación moderna, la vida de Charles Babbage brilló siempre

con el aura del genio pero desgraciadamente esa luz resultó invariablemente

opacada por la sombra de la incomprensión de un mundo que tendría que esperar

más de 70 años para apreciar la magnitud de los ambiciosos proyectos y del

legado de este polifacético matemático inglés.

(1791 - 1871) fue un matemático y astrónomo

británico. Al igual que sus colegas, podría haberse conformado con las máquinas

de calcular existentes en la década de 1830. Existían numerosos modelos de

estas máquinas, todos ellos

capaces de efectuar las cuatro operaciones

aritméticas. Pero Babbage

era un apasionado de la técnica y su proyecto era mucho más ambicioso: quería

construir una calculadora universal que pudiera encadenar automáticamente

cualquier secuencia de operaciones y devolver el resultado final.

(1791 - 1871) fue un matemático y astrónomo

británico. Al igual que sus colegas, podría haberse conformado con las máquinas

de calcular existentes en la década de 1830. Existían numerosos modelos de

estas máquinas, todos ellos

capaces de efectuar las cuatro operaciones

aritméticas. Pero Babbage

era un apasionado de la técnica y su proyecto era mucho más ambicioso: quería

construir una calculadora universal que pudiera encadenar automáticamente

cualquier secuencia de operaciones y devolver el resultado final.

9) Ada Lovelace

Ada Augusta Byron King (10 de diciembre de 1815, Londres, Reino Unido - 27 de noviembre de 1852, Londres, Reino Unido),[1] describió la máquina analítica de Charles Babbage, actualmente es considerada como la primera programadora, desde que escribió la manipulación de los símbolos, de acuerdo a las normas para una máquina de Charles Babbage que aún no había sido construida.

Máquina analítica de Charles Babbage

Ada Lovelace es recordada principalmente por haber escrito una descripción de la antigua máquina analítica de Charles Babbage, y por haber desarrollado instrucciones para hacer cálculos en una versión inicial del computador.En sus notas, Ada Augusta dice que la «máquina analítica» sólo podía dar información disponible que ya era conocida: vio claramente que no podía originar conocimiento. Su trabajo fue olvidado por muchos años, atribuyéndole exclusivamente un papel de transcriptora de las notas de Babbage. Este mismo caracterizó su aporte al llamarla su intérprete aunque recientes investigaciones muestran la originalidad de su punto de vista sobre las instrucciones necesarias para el funcionamiento de la «máquina analítica».

Hoy en día se reconoce a Ada Byron como la primera persona en describir un lenguaje de programación de carácter general interpretando las ideas de Babbage, pero reconociéndosele la plena autoría y originalidad de sus aportes. Ada Byron es la madre de la programación informática.

Ada Lovelace publicó en 1843 una serie de influyentes notas sobre el ordenador de Babbage, su «máquina analítica» que nunca llegó a construirse, aunque las firmó con sus iniciales por miedo a ser censurada por ser mujer. Ada Byron se llamó a sí misma una analista, un concepto realmente moderno para la época.

-Programas

Ada fue la primera persona en escribir un programa para un ordenador programable, escribió un "plan" donde describe los pasos que permitirían calcular los valores de los números de Bernoulli, su primer programa, que utilizaba dos bucles, con esto demostró la capacidad de bifurcación de la máquina de Babbage. También describió cómo se podían calcular operaciones trigonométricas que contaban con variables utilizando la máquina de Babbage.Dedujo y previó la capacidad de los ordenadores para ir más allá de los simples cálculos de números, mientras que otros, incluido el propio Babbage, se centraron únicamente en estas capacidades.[2] Su padre fue el famoso poeta Lord Byron.

Sugirió el uso de tarjetas perforadas como método de entrada de información e instrucciones a la máquina analítica. Además introdujo una notación para escribir programas, principalmente basada en el dominio que Ada tenía sobre el texto de Luigi Menabrea de 1842 (que comentó personalmente completándolo con anotaciones que son más extensas que el texto mismo) sobre el funcionamiento del telar de Jacquard así como de la máquina analítica de Babbage. Es reseñable además su mención sobre la existencia de ceros o estado neutro en las tarjetas perforadas siendo que las tarjetas representaban para la máquina de Babbage números decimales y no binarios (8 perforaciones equivaldrían entonces a 8 unidades).

10)George boole:

George Boole [buːl] (2 de noviembre de 1815 - 8 de diciembre de 1864) fue un matemático y filósofobritánico.

Como inventor del álgebra de Boole, que marca los fundamentos de la aritmética computacional moderna, Boole es considerado como uno de los fundadores del campo de las Ciencias de la Computación. En 1854 publicó "AnInvestigation of theLaws of Thought" en el que desarrollaba un sistema de reglas que le permitían expresar, manipular y simplificar problemas lógicos y filosóficos cuyos argumentos admiten dos estados (verdadero o falso) por procedimientos matemáticos. Se podría decir que es el padre de las operaciones lógicas y gracias a su álgebra hoy en día es posible manipular operaciones lógicas.

En el año 1847 el matemático inglés George Boole lo utilizó en ecuaciones algebraicas, estableciendo los fundamentos de los que sería la lógica de las computadoras.

11)Leonardo Torres Quevedo

(Santa Cruz de Iguña (Molledo), Cantabria, 28 de diciembre de 1852 – Madrid, 18 de diciembre de 1936) fue un ingeniero de Caminos, matemático e inventor español de finales del siglo XIX y principios del XX.

Máquinas analógicas de cálculo

Edificio

Torres Quevedo en el Centro Politécnico Superior de la Universidad de Zaragoza.

Las

máquinas analógicas de cálculo buscan la solución de

ecuaciones matemáticas mediante su traslado a fenómenos físicos. Los números se

representan por magnitudes físicas, que pueden ser rotaciones de determinados

ejes, potenciales, estados eléctricos o electromagnéticos, etcétera. Un proceso

matemático se transforma en estas máquinas en un proceso operativo de ciertas

magnitudes físicas que conduce a un resultado físico que se corresponde con la

solución matemática buscada. El problema matemático se resuelve pues mediante

un modelo físico del mismo. Desde mediados del siglo

XIX

se conocían diversos artilugios de índole mecánica, como integradores,

multiplicadores, etc., por no hablar de la máquina analítica de Charles Babbage; en esta tradición

se enmarca la obra de Torres Quevedo en esta materia, que se inicia en 1893 con la

presentación en la Academia de Ciencias Exactas, Físicas y Naturales de la Memoria

sobre las máquinas algébraicas. En su tiempo, esto fue considerado como un

suceso extraordinario en el curso de la producción científica española. En 1895

presenta la Memoria Sur les machines algébraiques en un Congreso en Burdeos.

Posteriormente, en 1900, presentará

la Memoria Machines á calculer en la Academia de Ciencias de París. En

ellas, examina las analogías matemáticas y físicas que son base del cálculo

analógico o de cantidades continuas, y cómo establecer mecánicamente las

relaciones entre ellas, expresadas en fórmulas matemáticas. Su estudio incluye

variables complejas, y utiliza la escala logarítmica. Desde el punto de vista

práctico, muestra que es preciso emplear mecanismos sin fin, tales como discos

giratorios, para que las variaciones de las variables sean ilimitadas en ambos

sentidos.

En

el terreno práctico, Torres Quevedo construyó toda una serie de máquinas

analógicas de cálculo, todas ellas de tipo mecánico —una de ellas es El Ajedrecista, presentado en la

feria de París de 1914—. En estas máquinas existen ciertos elementos,

denominados aritmóforos, que están constituidos por un móvil y un índice

que permite leer la cantidad representada para cada posición del mismo. El

móvil es un disco o un tambor graduado que gira en torno a su eje. Los

desplazamientos angulares son proporcionales a los logaritmos de las magnitudes

a representar. Utilizando una diversidad de elementos de este tipo, pone a

punto una máquina para resolver ecuaciones algebraicas: resolución de una

ecuación de ocho términos, obteniendo sus raíces, incluso las complejas, con

una precisión de milésimas. Un componente de dicha máquina era el denominado

«husillo sin fin», de gran complejidad mecánica, que permitía expresar

mecánicamente la relación y=log(10^x+1),

con el objetivo de obtener el logaritmo de una suma como suma de logaritmos. Como

se trataba de una máquina analógica, la variable puede recorrer cualquier valor

(no sólo valores discretos prefijados). Ante una ecuación polinómica, al girar

todas las ruedas representativas de la incógnita, el resultado final va dando

los valores de la suma de los términos variables, cuando esta suma coincida con

el valor del segundo miembro, la rueda de la incógnita marca una raíz.

Con

propósitos de demostración, Torres Quevedo también construyó una máquina para

resolver una ecuación de segundo grado con coeficientes complejos, y un

integrador. En la actualidad la máquina Torres Quevedo se conserva en el museo

de la ETS de Ingenieros de Caminos de la Universidad Politécnica

de Madrid

En

el terreno práctico, Torres Quevedo construyó toda una serie de máquinas

analógicas de cálculo, todas ellas de tipo mecánico —una de ellas es El Ajedrecista, presentado en la

feria de París de 1914—. En estas máquinas existen ciertos elementos,

denominados aritmóforos, que están constituidos por un móvil y un índice

que permite leer la cantidad representada para cada posición del mismo. El

móvil es un disco o un tambor graduado que gira en torno a su eje. Los

desplazamientos angulares son proporcionales a los logaritmos de las magnitudes

a representar. Utilizando una diversidad de elementos de este tipo, pone a

punto una máquina para resolver ecuaciones algebraicas: resolución de una

ecuación de ocho términos, obteniendo sus raíces, incluso las complejas, con

una precisión de milésimas. Un componente de dicha máquina era el denominado

«husillo sin fin», de gran complejidad mecánica, que permitía expresar

mecánicamente la relación y=log(10^x+1),

con el objetivo de obtener el logaritmo de una suma como suma de logaritmos. Como

se trataba de una máquina analógica, la variable puede recorrer cualquier valor

(no sólo valores discretos prefijados). Ante una ecuación polinómica, al girar

todas las ruedas representativas de la incógnita, el resultado final va dando

los valores de la suma de los términos variables, cuando esta suma coincida con

el valor del segundo miembro, la rueda de la incógnita marca una raíz.

Con

propósitos de demostración, Torres Quevedo también construyó una máquina para

resolver una ecuación de segundo grado con coeficientes complejos, y un

integrador. En la actualidad la máquina Torres Quevedo se conserva en el museo

de la ETS de Ingenieros de Caminos de la Universidad Politécnica

de Madrid12)Tim Berners-Lee

Ante la necesidad de distribuir e intercambiar información acerca de sus investigaciones de una manera más efectiva, Berners-Lee desarrolló las ideas fundamentales que estructuran la web. Él y su grupo crearon lo que por sus siglas en inglés se denomina Lenguaje HTML (HyperText Markup Language) o lenguaje de etiquetas de hipertexto, el protocolo HTTP (HyperText Transfer Protocol) y el sistema de localización de objetos en la web URL (Uniform Resource Locator).

Es posible encontrar muchas de las ideas plasmadas por Berners-Lee en el proyecto Xanadu (que propuso Ted Nelson) y el memex (de Vannevar Bush).

Berners-Lee trabajó en el CERN desde junio hasta diciembre de 1980. Durante ese tiempo, propuso un proyecto basado en el hipertexto para facilitar la forma de compartir y la puesta al día de la información entre investigadores. En este periodo también construyó un programa llamado ENQUIRE que no llegó a ver la luz.

Después de dejar el CERN, en 1980, se fue a trabajar a la empresa de John Poole Image Computer Systems Ltd., pero regresó al CERN otra vez en 1984.

En 1989, el CERN era el nodo de Internet más grande de Europa y Berners-Lee vio la oportunidad de unir Internet y el hipertexto (HTTP y HTML), de lo que surgiría la World Wide Web. Desarrolló su primera propuesta de la Web en marzo de 1989, pero no tuvo mucho eco, por lo que en el 1990 y con la ayuda de Robert Cailliau, hicieron una revisión que fue aceptada por su gerente, Mike Sendall. Usó ideas similares a las que había usado en el sistema Enquire para crear la World Wide Web, para esto diseñó y construyó el primer navegador (llamado WorldWideWeb y desarrollado con NEXTSTEP) y el primer servidor Web al que llamó httpd (HyperText Transfer Protocol daemon).

El primer servidor Web se encontraba en el CERN y fue puesto en línea el 6 de agosto de 1991. Esto proporcionó una explicación sobre lo que era el World Wide Web, como uno podría tener un navegador y como establecer un servidor Web. Este fue también el primer directorio Web del mundo, ya que Berners-Lee mantuvo una lista de otros sitios Web aparte del suyo. Debido a que tanto el software del servidor como del cliente fue liberado de forma gratuita desde el CERN, el corazón de Internet Europeo en esa época, su difusión fue muy rápida. El número de servidores Web pasó de veintiséis de 1992 a doscientos en octubre de 1995 lo que refleja cual fue la velocidad de la difusión de internet.

En 1994 entró en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial del Massachusetts Institute of Technology. Se trasladó a EE.UU. y puso en marcha el W3C, que dirige actualmente. El W3C es un organismo internacional de estandarización de tecnologías Web dirigido conjuntamente por el Instituto Tecnológico de Massachusetts, el ERCIM francés y la Universidad de Keiō en Japón. Este organismo decidió que todos sus estándares fuesen libres, es decir, que los pudiese utilizar todo el mundo libremente sin coste alguno, lo que sin lugar a dudas fue una de las grandes razones para que la Web haya llegado a tener la importancia que tiene hoy en día.

En su libro Tejiendo la red, publicado en 1999, Tim Berners-Lee explica por qué la tecnología web es libre y gratis. Se considera al mismo tiempo el inventor y el protector de la web.

13)Bill Gates

William Henry Gates III (nacido el 28 de

octubre de 1955 en Seattle, Washington), más conocido

como Bill Gates, es un

empresario y filántropo estadounidense, cofundador de la

empresa de software Microsoft, productora del sistema

operativo para computadoras personales más utilizado en el mundo,

Microsoft Windows.

Cuando, en 1986, Microsoft salió a la

Bolsa, las acciones se cotizaron tan alto que Bill Gates se convirtió en el hombre más rico de Estados

Unidos. Desde entonces, el negocio no ha cesado de crecer (de

los 1.200 empleados que tenía en 1986 hasta más de 20.000 en 1996), obteniendo

un virtual monopolio del

mercado del software mundial (reforzado por su victoria en el

pleito contra Apple en

1992, un capítulo aparte).

Las innovaciones

siguieron llegando, las nuevas versiones Windows, como la 3.0 (muy bien recibida

por los usuarios), Windows

95, 98 y las sucesivas versiones de este sistema operativo

hasta llegar a los actuales XP

y Vista.

Actualmente ha

delegado la dirección de Microsoft para concentrar sus energías en fundaciones benéficas

en las cuales trabaja junto a su esposa.

14)Steve Jobs

Steven Paul Jobs (San Francisco, California, 24 de febrero de 1955 – Palo Alto, California, 5 de octubre de 2011),[8] [9] [10] [11] más conocido como Steve Jobs, fue un empresario y magnate de los negocios del sector informático y de la industria del entretenimiento estadounidense. Fue cofundador y presidente ejecutivo de Apple Inc.[12] y máximo accionista individual de The Walt Disney Companny.

Inicios de Apple Computer

Debido a las exigencias de su contrato con Hewlett-Packard, Wozniak tuvo que dar a conocer su intención de construir un computador personal para la empresa, que desechó la idea por considerarla ridícula.[cita requerida] Fue así como en 1976 nació Apple Computer Company.[26]Tras la consecución del primer computador personal, bautizado como Apple I, Jobs se dedicó a su promoción entre otros aficionados a la informática, tiendas y ferias de electrónica digital, llegando a vender unos 200 ejemplares. A partir de entonces, el crecimiento de Apple fue notable. En tan sólo 10 años, Apple se convirtió en una empresa con 4.000 empleados y Jobs, con 27 años, era el millonario más joven de 1982. [cita requerida]

A principios de 1983 vio la luz Lisa, un computador personal diseñado especialmente para gente con poca experiencia en informática. Su precio, más caro que el de la mayoría de ordenadores personales de la competencia, no facilitó que el nuevo producto fuese precisamente un éxito de ventas, perdiendo Apple aproximadamente la mitad de su cuota de mercado en favor de IBM.[25]

En un intento por mantener la competitividad de la compañía, Steve Jobs, ya convertido en ejecutivo, convenció a John Sculley, director ejecutivo de Pepsi-Cola, para tomar las riendas de Apple.[24]

En la conferencia anual de Apple del 24 de enero de 1984, Jobs presentó con grandes expectativas, el Apple Macintosh, el primer ordenador personal con interfaz gráfica de usuario y ratón, inventados por Xerox Alto. Macintosh no alcanzó, sin embargo, las expectativas comerciales esperadas[]

Hacia finales de 1984 las diferencias entre Sculley y Jobs se iban haciendo cada vez más insalvables, hasta el punto de deteriorarse la relación. En mayo de 1985, en medio de una profunda reestructuración interna que se saldó con el despido de 1.200 empleados, Sculley relegó a Jobs de sus funciones como líder de la división de Macintosh.[][]

Tras varios meses de resignación, el 13 de septiembre de 1985, Steve Jobs abandonó la compañía que él mismo había fundado.[cita requerida]

Fundación de Pixar

Tras abandonar Apple en 1986, Steve Jobs compra por 10 millones de dólares la empresa The Graphics Group, conocida en lo sucesivo como Pixar, una subsidiaria de Lucasfilm especializada en la producción de gráficos por computador.[33]Steve Jobs empezó a firmar varios acuerdos para producir películas animadas para la compañía Walt Disney.[24] En 1995 se estrenó en los cines Toy Story, el primer largometraje generado completamente por computadora, conseguido con su propio software de renderización, RenderMan. Toy Story fue el mayor éxito de taquilla de 1995 y la primera película del binomio Walt Disney-Pixar en ganar un premio Óscar.

A esta película la siguieron Bichos (1998), Monsters, Inc. (2001) Buscando a Nemo (2003), Cars (2006), WALL-E (2008) y Up (2009), entre otras, las cuales obtuvieron la aprobación de la crítica y el público.

15)Alan Shugart

Nacido en Los Ángeles, California, se graduo en la Universidad de Redlands, recibiendo su diploma en ingeniería física.

Comenzó su carrera en IBM en 1951, en San Jose, California, reparando maquinas contable de tarjetas perforadas. Trabajó en el proyecto de IBM RAMAC 305 (del inglés Random Access Method of Accounting and Control) que permitía almacenar 5 millones de caracteres de datos. Dentro de los proyectos también fue participé del IBM 1301, un disco de 50 MB el cual fue la base para múltiples empresas de servicios. Llegó a ocupar posiciones de importancia hasta ser el Direct Access Storage Product Manager, responsable de los productos de almacenamiento; que era en ese momento en IBM uno de los negocios mas provechosos. Entre los grupos que repotaba a Shugart, estaba el del grupo que inventó el disco flexible (floppy disk).

En 1969 deja IBM y pasa a Memorex; en 1972 deja Memorex para fundar Shugart Associates en 1973, más adelante adquirido por Xerox. Luego el y Finis Conner comienzan con Shugart Technology en 1979, cambiando su nombre a Seagate Technology.

Con Shugart como Chief Executive Officer, Seagate se convirtió en el mayor fabricante mundial independiente de discos duros y componentes relativos.

Recibe en 1997 el premio de la IEEE "Reynold B. Johnson Information Storage Systems Award".

En julio de 1998, dimite de su posición en Seagate.

Shugart muere el 12 de diciembre de 2006 en Monterrey, California, por complicaciones en su corazón, de la cirugía realizada seis semanas antes.

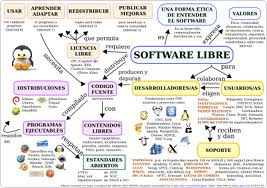

16)Richard Stallman

Richard Matthew Stallman (nacido en Manhattan, Nueva York, 16 de marzo de 1953), con frecuencia abreviado como "rms",[1] es un programador estadounidense y fundador del movimiento por el software libre en el mundo. Entre sus logros destacados como programador se incluye la realización del editor de texto GNU Emacs,[2] el compilador GCC,[3] y el depurador GDB,[4] bajo la rúbrica del Proyecto GNU. Sin embargo, es principalmente conocido por el establecimiento de un marco de referencia moral, político y legal para el movimiento del software libre, como una alternativa al desarrollo y distribución del software no libre o privativo. Es también inventor del concepto de copyleft (aunque no del término), un método para licenciar software de tal forma que su uso y modificación permanezcan siempre libres y queden en la comunidad.

Fundador del Movimiento del software libre, de la FSF y del Proyecto GNU

Software Libre

Stallman insiste en la utilización del término Software Libre, y no código abierto, porque lo importante es la libertad del usuario que se pierde. También busca que se utilice GNU/Linux y no solamente Linux cuando se habla del sistema operativo

17)Howard H. Aiken

Howard H. Aiken (Hoboken, Nueva Jersey, 9 de marzo de 1900 - San Luis, Misuri, 14 de marzo de 1973), ingeniero estadounidense, pionero en computación al ser el ingeniero principal tras el Mark I. Estudio en la Universidad de Wisconsin-Madison, y posteriormente obtuvo su doctorado en física en la Universidad Harvard en 1939. Durante este tiempo, encontró ecuaciones diferenciales que sólo podía resolver numéricamente. Ideó un dispositivo electromecánico de computación que podía hacer gran parte de ese trabajo por él. Este ordenador fue originalmente llamado Automatic Sequence Controlled Calculator (ASCC) y posteriormente renombrado Harvard Mark I. Con la ayuda de Grace Hopper y financiación de IBM, la máquina fue completada en 1944.

En 1947, Aiken completó su trabajo en el ordenador Harvard Mark II. Continúo su trabajo en el Mark III y en el Harvard Mark IV. El Mark III utilizó algunos componentes electrónicos y el Mark IV fue completamente electrónico. El Mark III y el Mark IV utilizaron memoria de tambor magnético y el Mark IV también tenía un núcleo de memoria magnética. Vivió en México en la parte de Puebla.

Aiken fue inspirado por la Máquina Diferencial de Charles Babbage. De él, se supone que dijo en 1947: "Sólo seis ordenadores digitales electrónicos serían necesarios para satisfacer las necesidades de computación de todos los Estados Unidos." La cita también es atribuida a Thomas John Watson, pero probablemente no fue dicha por ninguno de los dos.

En 1970, Aiken recibió la Medalla Edison del IEEE por 'Una meritoria carrera de contribuciones pioneras al desarrollo y la aplicación de ordenadores digitales de gran escala e importantes contribuciones a la educación en el campo de los ordenadores digitales.

18) Grace Morley

Dra. Grace Louise McCann Morley (1900-1985) fue un museólogo de la influencia global. Ella fue la fundadora de San Francisco Museum of Modern Art, y su director durante 23 años a partir de 1934. La revista Time publicó un artículo en su vigésimo año con el museo, y luego otro artículo sobre su retiro. En una entrevista con Thomas Tibbs, que se acredita con ser una fuerza importante en el fomento de jóvenes artistas americanos.

Durante estos años, ella era activa en el mundo del arte en los EE.UU.. Fue Segundo Vicepresidente de la Federación Americana de las Artes, 1939; Consejero para las Artes en la Oficina de Asuntos Interamericanos de 1941, un miembro del Comité de los edificios de Bellas Artes de la Exposición Internacional de San Francisco y Director de la Casa del Pacífico 1940, un miembro de la Comisión de Expertos en las Artes del Departamento de Estado, 1940-1945. Entre 1946-1949, se despidió de San Francisco Museum of Art, y se convirtió en Asesor de Museos de la UNESCO de la Comisión Preparatoria, y luego como Jefe de la División de Museos.

Ella fue autor de algunos artículos de números de Arte Contemporáneo, y en las civilizaciones de América Latina.

Ella se trasladó a la India en 1960, y permaneció allí hasta su muerte en 1985. Fue directora fundadora del Museo Nacional de Nueva Delhi y fue galardonado con el Padma Bhushan por el gobierno de la India.

Su carrera incluyó un periodo como Curador del Museo de Arte de Cincinnati, Ohio, a partir de 1930. Ella era activa en el Consejo Internacional de Museos (ICOM), y fue el Director de la Agencia Regional del ICOM para el sur y sudeste de Asia desde 1967 hasta 1978.

Dr. Morley tenía un D.Litt. doctorado en París, Francia en el arte y la literatura (1926), un título honorario de universidad de los molinos (1937), y un honorario de "Doctor en Letras Humanas" grado de Smith en 1957.

Becas de investigación en su honor se otorgan por el ICOM India Trust cada año. El San Francisco Museum of Modern Art ha establecido el legado de Grace McCann Morley Sociedad para los donantes que proporcionan para el museo en sus planes de bienes raíces. En la India, el Museo Nacional del Instituto cuenta con una anual de la Dra. Grace Morley Seminario Conmemorativo.

19)John William Mauchly

John William Mauchly (30 de agosto de 1907 – 8 de enero de 1980) fue un físico estadounidense que, junto con John Presper Eckert, diseñaron la ENIAC, el primer programa y el primer ordenador digital electrónico de propósito general[cita requerida] así como el EDVAC, el Binac y el UNIVAC. Y el primer ordenador comercial hecho en los Estados Unidos. Los dos empezaron la primera compañía de ordenadores, la Eckert-Mauchly Computer Corporation y fueron pioneros en algunos conceptos fundamentales de los ordenadores, incluyendo el “programa almacenado”, las subrutinas y los lenguajes de programación. Su trabajo, tal y como se expone su primer borrador del informe del EDVAC (1945) y tal y como se explica en las “Moore School Lectures” (1946) influenció una explosión en el desarrollo de ordenadores a finales de los 40 en cualquier parte del mundo.

El interés de Mauchly recae en las aplicaciones de ordenadores, así como en su arquitectura y organización. Su experiencia programando la ENIAC y sus sucesores lo llevaron a crear el "SHORT CODE", el primer lenguaje de programación usado actualmente en un ordenador (precedido por el conceptual Plankalkul de Zuse). Era un intérprete de pseudo-código para problemas matemáticos propuesto al 1949 y que funcionó sobre el UNIVAC I y el II. La creencia de Mauchly en la importancia de los lenguajes lo trajeron a contratar a Grace Murray Hopper para desarrollar un compilador para el UNIVAC.

A John Mauchly se le ha reconocido también el ser el primero en usar el verbo "programar" en su artículo de 1942 sobre ordenadores electrónicos, aun cuando fue en el contexto del ENIAC y no en su significado actual.

20)Douglas Carl Engelbart

(n. en Oregón, Estados

Unidos, el 30 de enero de 1925) es un inventor

estadounidense, descendiente de noruegos.

Es conocido por inventar el ratón, y es un pionero de la interacción humana

con las computadoras, incluyendo el hipertexto y lascomputadoras en red.

Engelbart

recibió un título de

grado en ingeniería eléctrica de la Oregon State University en1948, un título de grado

en ingeniería de la Universidad de Berkeley en 1952 y un doctorado de UC Berkeley en 1955.

En

otoño de 1968, en una conferencia de expertos en informática, Doug Engelbart

hizo una presentación que duró 90 minutos. Además de hacer la primera

demostración pública del ratón, incluyó una conexión en pantalla con su centro

de investigación, es decir, fue la primera vídeo-conferencia de la historia.

Como

operario de radar en las Filipinas durante la Segunda Guerra Mundial, Engelbart se

inspiró en un artículo de Vannevar Bush,

'As We May Think', para buscar la manera de usar las computadoras para mejorar

la sociedad. Cuando terminó la guerra, y siguiendo esta idea, Engelbart

renunció a su trabajo como ingeniero y se fue a estudiar a UC Berkeley. Allí

trabajó en la versión previa de Internet,

la red militar ARPANET.

Engelbart fue la fuerza motriz detrás del diseño del primer sistema en línea,

On-Line System (también conocido como NLS), en elStanford Research Institute.

Su oficina fue el segundo nodo de la red. Junto con su equipo en el

Augmentation Research Center desarrolló varios elementos básicos de la interfaz

humana de las computadoras actuales, como pantallas con imágenes en bits, ventanas múltiples, ysoftware multiusuario.

También fue el co-inventor del mouse, del que nunca

recibió regalías.

Sus

ideas radicales no tuvieron la aceptación que esperaba, y fue perdiendo

presupuesto para sus investigaciones. En 1978 el laboratorio se cerró por falta

de fondos, aunque el sistema NLS y su sucesor, Augment, fueron vendidos a

Tymshare, una compañía que más tarde fue comprada por McDonnell

Douglas. Parte de su equipo se fue al centro de investigación Xerox PARC,

donde siguieron desarrollando el mouse y desarrollaron la interfaz gráfica.

En

1988 Engelbart y su hija, Christina, fundaron el Bootstrap Institute, una entidad que aconsejaría a empresas sobre cómo

usar la tecnología para lograr una mejor organización.

Dos décadas después la entidad cambió su nombre por el de Doug Engelbart

Institute.1

Engelbart

recibió varios premios en los últimos años, como el Premio Memorial Yuri

Rubinsky, el Premio Lemelson-MIT, el Premio Turing,

la Medalla John von Neumann y la Medalla British Computer

Society's Lovelace.

En

1997, le fue concedido el Premio Lemelson-MIT, del Instituto Tecnológico de

Massachusetts. Este premio está dotado con medio millón de dólares.

Su mérito no es haber inventado el mouse, sino 'haber descubierto la interfaz

entre los ordenadores y los seres humanos'.

El hombre que invento el raton:

Doug

Engelbart es el inventor del ratón y de una increíble cantidad de cosas y

procesos que ahora nos resultan familiares a todos. En otoño de 1968, en una

conferencia de expertos en informática, Doug Engelbart hizo una presentación

que duró 90 minutos. Además de hacer la primera demostración pública del ratón,

incluyó una conexión en pantalla con su centro de investigación, es decir, fue

la primera vídeo-conferencia de la historia ¡Un año antes de la primera

conexión ARPANET!

21)Vinton cerf

Vinton 'Vint' Gray Cerf es un científico de la computación estadounidense,

considerado uno de los 'padres' de Internet.

Nacido en Connecticut (Estados

Unidos) en 1943, de origen judío, se

graduó en matemáticas y ciencias de la computación en la Universidad de Stanford (1965). Durante su estancia

posterior en la Universidad de California (UCLA) obtuvo la maestría

en ciencias y el doctorado.

A

principios de los años 70 comenzó a trabajar con Robert Kahn en el desarrollo de un conjunto de

protocolos de comunicaciones para la red militar, financiado por la agencia

gubernamental DARPA. El objetivo era

crear una "red de redes" que permitiera interconectar las distintas

redes del Departamento de Defensa de los

Estados Unidos, todas ellas de diferentes tipos y que funcionaban

con diferentes sistemas

operativos, con independencia del tipo de conexión: radioenlaces, satélites y líneas telefónicas.

Las

investigaciones, lideradas por Vinton Cerf, primero desde la Universidad de

California (1967-1972) y posteriormente

desde la Universidad de Stanford (1972-1976),

llevaron al diseño del conjunto de protocolos que hoy son conocidos como TCP/IP (Transmission Control

Protocol/Internet Protocol), que fue presentado por Vinton Cerf y Robert Kahn en 1972.

Entre 1976 y 1982, trabajando en DARPA, fue pionero en el

desarrollo de la transmisión por radio y satélite de paquetes, responsable del

proyecto Internet y del programa de investigación de

seguridad en la red. Siempre preocupado por los problemas de conexión de redes,

Cerf estableció en 1979 la Internet Configuration Control

Board (que posteriormente se denominó Internet Activities Board), y fue su

primer presidente.

Entre 1982 y 1986, Cerf diseñó el MCI

MAIL, primer servicio comercial de correo electrónicoque se conectaría a Internet.

En 1992 fue uno de los fundadores de la Internet Society y su primer presidente.

Actualmente

Vinton Cerf es el vicepresidente mundial y Chief Internet Evangelist de Google,

ocupación que compagina con el cargo de presidente del ICANN. Es miembro del Consejo Asesor

Internacional del Centro Cultural Internacional Oscar

Niemeyer de Avilés, Ast

y asi entre si entre michos otros personajes mas .

y asi entre si entre michos otros personajes mas .

Herman+Hollerith+%28.jpeg)

Vannevar+Bush.jpeg)

Norbert+Wiener.jpeg)

Claude+Elwood+Shannon.jpeg)

Charles+Babbage.jpeg)

Leonardo+Torres+Quevedo.jpeg)

Tim+Berners-Lee.jpeg)

Bill+Gates.jpeg)

Steve+Jobs.jpeg)

Alan+Shugart.jpeg)

Richard+Stallman.jpeg)

Howard+H.+Aiken.jpeg)

John+William+Mauchly.jpeg)

Douglas+Carl+Engelbart.jpeg)

Vinton+cerf.jpeg)

No hay comentarios:

Publicar un comentario